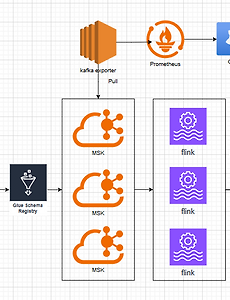

[Kafka] 실시간 데이터(스트리밍) 처리 데이터 파이프라인 설계, tool 비교 정리 3) 이상 데이터 탐지,백업,모니터링,분석, 최종 파이프라인

이번 포스트에는 프로듀서, 브로커, 컨슈머를 제외한 나머지들 이상 데이터를 탐지할 때, 백업 방법, 모니터링 과 분석용 툴들을 정리해보고 최종 파이프라인을 그려보고 운영 단계에서 효율적이라고 생각하는 최종 파이프라인을 구성해보겠습니다. 1편(broker 비교, kafka vs kinesis)https://spidyweb.tistory.com/5992편(consumer 비교, flink, spark streaming, kafka streaming, logstash, kinesis firehose)https://spidyweb.tistory.com/6003편(이상 데이터 탐지, 백업, 모니터링, 분석, 파이프라인 및 최종)https://spidyweb.tistory.com/6011. 이상 데이터 탐지굳이 파..

2025. 5. 7.

[Kafka] 실시간 데이터(스트리밍) 처리 데이터 파이프라인 설계, tool 비교 정리 3) 이상 데이터 탐지,백업,모니터링,분석, 최종 파이프라인

이번 포스트에는 프로듀서, 브로커, 컨슈머를 제외한 나머지들 이상 데이터를 탐지할 때, 백업 방법, 모니터링 과 분석용 툴들을 정리해보고 최종 파이프라인을 그려보고 운영 단계에서 효율적이라고 생각하는 최종 파이프라인을 구성해보겠습니다. 1편(broker 비교, kafka vs kinesis)https://spidyweb.tistory.com/5992편(consumer 비교, flink, spark streaming, kafka streaming, logstash, kinesis firehose)https://spidyweb.tistory.com/6003편(이상 데이터 탐지, 백업, 모니터링, 분석, 파이프라인 및 최종)https://spidyweb.tistory.com/6011. 이상 데이터 탐지굳이 파..

2025. 5. 7.