[BigData] Apache Airflow 설치 및 실습하기 series (2) Airflow 2.1 ubuntu 20.04에 설치하기

안녕하세요 이번 포스트에는 Airflow만 독단적으로 설치해보겠습니다. 다음포스트에는 DAG파일을 집중분석하여 실습해보도록 하겠습니다. 준비사항 우분투 20.04 LTS 서버와 충분한 디스크 공간 sudo 와 root접근 권한이 있는 계정 Python:3.6,3.7,3.8 버전(3.9는 지원안한다) PostgreSQL(9.6,10,11,12,13), MySQL(5.7,8), SQLite(3.15.0+) *우리는 Apache Airflow에 MySQL 5.7버전을 사용할 것입니다. 혹시 ubuntu가 깔려있지 않으시다면 아래의 글을 참고해주세요. 2021.04.26 - [BigData] - [Hadoop] virtual box linux [ubuntu 18.04]에 하둡 설치,다운로드 1.virtualbo..

2021. 10. 17.

[BigData] Apache Airflow 설치 및 실습하기 series (2) Airflow 2.1 ubuntu 20.04에 설치하기

안녕하세요 이번 포스트에는 Airflow만 독단적으로 설치해보겠습니다. 다음포스트에는 DAG파일을 집중분석하여 실습해보도록 하겠습니다. 준비사항 우분투 20.04 LTS 서버와 충분한 디스크 공간 sudo 와 root접근 권한이 있는 계정 Python:3.6,3.7,3.8 버전(3.9는 지원안한다) PostgreSQL(9.6,10,11,12,13), MySQL(5.7,8), SQLite(3.15.0+) *우리는 Apache Airflow에 MySQL 5.7버전을 사용할 것입니다. 혹시 ubuntu가 깔려있지 않으시다면 아래의 글을 참고해주세요. 2021.04.26 - [BigData] - [Hadoop] virtual box linux [ubuntu 18.04]에 하둡 설치,다운로드 1.virtualbo..

2021. 10. 17.

[Hive] Hive의 성능(테이블) (3) bucketing(버켓팅),skew(스큐), serde(서데), join type(맵 조인, 셔플 조인, 정렬-병합 조인)정리

이번 포스트에는 이전 포스트에서 전부 다루지는 못했던, Hive의 성능에 관한 것들을 위주로 다루어 보겠습니다. *Hive의 개념을 모르신다면 아래를 참조해주세요 2021.07.12 - [BigData] - [Hive] Hive란?(1) 개념, 구성요소, 등장배경, 버전 [Hive] Hive란?(1) 개념, 구성요소, 등장배경, 버전 1. Hive란? -하이브는 하둡 에코시스템 중에서 데이터를 모델링하고 프로세싱하는 경우 가장 많이 사용하는 데이터 웨어하우징용 솔루션입니다. -RDB의 데이터베이스, 테이블과 같은 형태로 HDFS에 spidyweb.tistory.com *Hive의 메타스토어, Partition에 대해서 모르신다면 아래를 참조해주세요. 2021.06.27 - [BigData] - [Hive..

2021. 10. 5.

[Hive] Hive의 성능(테이블) (3) bucketing(버켓팅),skew(스큐), serde(서데), join type(맵 조인, 셔플 조인, 정렬-병합 조인)정리

이번 포스트에는 이전 포스트에서 전부 다루지는 못했던, Hive의 성능에 관한 것들을 위주로 다루어 보겠습니다. *Hive의 개념을 모르신다면 아래를 참조해주세요 2021.07.12 - [BigData] - [Hive] Hive란?(1) 개념, 구성요소, 등장배경, 버전 [Hive] Hive란?(1) 개념, 구성요소, 등장배경, 버전 1. Hive란? -하이브는 하둡 에코시스템 중에서 데이터를 모델링하고 프로세싱하는 경우 가장 많이 사용하는 데이터 웨어하우징용 솔루션입니다. -RDB의 데이터베이스, 테이블과 같은 형태로 HDFS에 spidyweb.tistory.com *Hive의 메타스토어, Partition에 대해서 모르신다면 아래를 참조해주세요. 2021.06.27 - [BigData] - [Hive..

2021. 10. 5.

[BigData] 완전 분산 하둡 클러스터(hadoop cluster)구축하기(4개 노드) 7. 하둡 설치, 배포, 환경설정, 실행하기

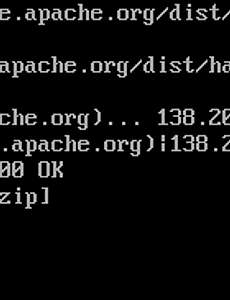

이번 포스트에는 hadoop 설치, 배포, 환경설정, 실행하기를 해보겠습니다. 아직 zookeeper 설치,환경설정,실행을 완료해보지 못했다면 아래의 링크를 참고해주세요. https://spidyweb.tistory.com/271 [BigData] Centos-7 fully distributed hadoop cluster 구성하기(하둡 클러스터) 6. Zookeeper 설치, 환경설정, 실행 이번 포스트에는 zookeeper 를 설치하고, 환경설정하여 실행 해보겠습니다. 아직 zookeeper 및 hadoop 계정 생성과 권한 설정을 완료하지 못했다면 아래의 링크를 참고해주세요. https://spidyweb.tistory.com/27 spidyweb.tistory.com 하둡 구성 스펙 호스트OS - ..

2021. 8. 12.

[BigData] 완전 분산 하둡 클러스터(hadoop cluster)구축하기(4개 노드) 7. 하둡 설치, 배포, 환경설정, 실행하기

이번 포스트에는 hadoop 설치, 배포, 환경설정, 실행하기를 해보겠습니다. 아직 zookeeper 설치,환경설정,실행을 완료해보지 못했다면 아래의 링크를 참고해주세요. https://spidyweb.tistory.com/271 [BigData] Centos-7 fully distributed hadoop cluster 구성하기(하둡 클러스터) 6. Zookeeper 설치, 환경설정, 실행 이번 포스트에는 zookeeper 를 설치하고, 환경설정하여 실행 해보겠습니다. 아직 zookeeper 및 hadoop 계정 생성과 권한 설정을 완료하지 못했다면 아래의 링크를 참고해주세요. https://spidyweb.tistory.com/27 spidyweb.tistory.com 하둡 구성 스펙 호스트OS - ..

2021. 8. 12.